TensorFlow 模型训练

TensorFlow 提供了构建和训练神经网络模型的全套工具。

模型训练是指通过数据让模型自动调整参数,从而获得预测能力的过程。

模型训练的核心要素

- 数据:训练集、验证集和测试集

- 模型架构:神经网络的层结构和连接方式

- 损失函数:衡量模型预测与真实值差异的指标

- 优化器:调整模型参数的算法

- 评估指标:衡量模型性能的标准

训练流程

1、数据准备

实例

import tensorflow as tf

from tensorflow.keras import datasets

# 加载数据集(以MNIST为例)

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

# 数据预处理

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255

# 转换为TensorFlow Dataset

train_dataset = tf.data.Dataset.from_tensor_slices((train_images, train_labels))

train_dataset = train_dataset.shuffle(10000).batch(64)

from tensorflow.keras import datasets

# 加载数据集(以MNIST为例)

(train_images, train_labels), (test_images, test_labels) = datasets.mnist.load_data()

# 数据预处理

train_images = train_images.reshape((60000, 28, 28, 1)).astype('float32') / 255

test_images = test_images.reshape((10000, 28, 28, 1)).astype('float32') / 255

# 转换为TensorFlow Dataset

train_dataset = tf.data.Dataset.from_tensor_slices((train_images, train_labels))

train_dataset = train_dataset.shuffle(10000).batch(64)

2、模型构建

实例

from tensorflow.keras import layers, models

# 构建Sequential模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10, activation='softmax')

])

# 查看模型结构

model.summary()

# 构建Sequential模型

model = models.Sequential([

layers.Conv2D(32, (3, 3), activation='relu', input_shape=(28, 28, 1)),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.MaxPooling2D((2, 2)),

layers.Conv2D(64, (3, 3), activation='relu'),

layers.Flatten(),

layers.Dense(64, activation='relu'),

layers.Dense(10, activation='softmax')

])

# 查看模型结构

model.summary()

3、模型编译

实例

model.compile(optimizer='adam',

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

loss='sparse_categorical_crossentropy',

metrics=['accuracy'])

编译参数说明

| 参数 | 可选值 | 说明 |

|---|---|---|

| optimizer | 'adam', 'sgd', 'rmsprop' 等 | 优化算法选择 |

| loss | 'mse', 'categorical_crossentropy' 等 | 损失函数类型 |

| metrics | ['accuracy'], ['mse'] 等 | 评估指标列表 |

4、模型训练

实例

history = model.fit(train_dataset,

epochs=10,

validation_data=(test_images, test_labels))

epochs=10,

validation_data=(test_images, test_labels))

fit() 方法主要参数

| 参数 | 类型 | 说明 |

|---|---|---|

| x | 输入数据 | 训练数据 |

| y | 目标数据 | 标签数据 |

| epochs | 整数 | 训练轮数 |

| batch_size | 整数 | 每批数据量 |

| validation_data | 元组 | 验证数据集 |

| callbacks | 列表 | 回调函数列表 |

训练过程可视化

训练曲线

实例

import matplotlib.pyplot as plt

# 绘制训练和验证的准确率曲线

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.show()

# 绘制训练和验证的准确率曲线

plt.plot(history.history['accuracy'], label='Training Accuracy')

plt.plot(history.history['val_accuracy'], label='Validation Accuracy')

plt.xlabel('Epoch')

plt.ylabel('Accuracy')

plt.legend()

plt.show()

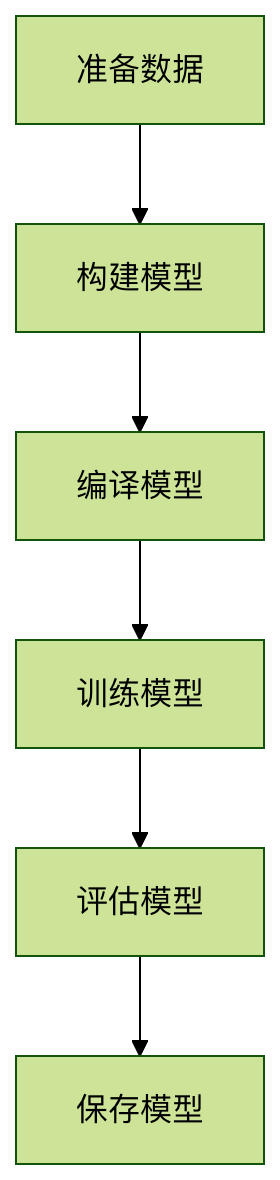

训练流程图

高级训练技巧

自定义训练循环

实例

# 定义损失函数和优化器

loss_fn = tf.keras.losses.SparseCategoricalCrossentropy()

optimizer = tf.keras.optimizers.Adam()

# 自定义训练步骤

@tf.function

def train_step(images, labels):

with tf.GradientTape() as tape:

predictions = model(images)

loss = loss_fn(labels, predictions)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

return loss

# 自定义训练循环

for epoch in range(10):

for images, labels in train_dataset:

loss = train_step(images, labels)

print(f'Epoch {epoch}, Loss: {loss.numpy()}')

loss_fn = tf.keras.losses.SparseCategoricalCrossentropy()

optimizer = tf.keras.optimizers.Adam()

# 自定义训练步骤

@tf.function

def train_step(images, labels):

with tf.GradientTape() as tape:

predictions = model(images)

loss = loss_fn(labels, predictions)

gradients = tape.gradient(loss, model.trainable_variables)

optimizer.apply_gradients(zip(gradients, model.trainable_variables))

return loss

# 自定义训练循环

for epoch in range(10):

for images, labels in train_dataset:

loss = train_step(images, labels)

print(f'Epoch {epoch}, Loss: {loss.numpy()}')

回调函数使用

实例

from tensorflow.keras.callbacks import ModelCheckpoint, EarlyStopping

# 创建回调函数

callbacks = [

ModelCheckpoint('best_model.h5', save_best_only=True),

EarlyStopping(patience=3, monitor='val_loss')

]

# 使用回调训练

model.fit(train_dataset,

epochs=20,

validation_data=(test_images, test_labels),

callbacks=callbacks)

# 创建回调函数

callbacks = [

ModelCheckpoint('best_model.h5', save_best_only=True),

EarlyStopping(patience=3, monitor='val_loss')

]

# 使用回调训练

model.fit(train_dataset,

epochs=20,

validation_data=(test_images, test_labels),

callbacks=callbacks)

常见问题与解决方案

训练问题排查表

| 问题现象 | 可能原因 | 解决方案 |

|---|---|---|

| 损失不下降 | 学习率过高/过低 | 调整学习率 |

| 准确率波动大 | 批量大小不合适 | 调整batch_size |

| 过拟合 | 模型太复杂 | 添加正则化或Dropout |

| 训练速度慢 | 硬件限制 | 使用GPU加速或减小模型 |

性能优化建议

数据管道优化:

实例

# 使用prefetch和cache加速数据加载

train_dataset = train_dataset.cache().prefetch(buffer_size=tf.data.AUTOTUNE)

混合精度训练:

实例

policy = tf.keras.mixed_precision.Policy('mixed_float16')

tf.keras.mixed_precision.set_global_policy(policy)

分布式训练:

实例

strategy = tf.distribute.MirroredStrategy()

with strategy.scope():

model = create_model()

model.compile(...)

实践练习

练习1:基础训练

使用Fashion MNIST数据集,构建一个CNN模型并完成训练,要求:

- 至少包含2个卷积层

- 训练10个epoch

- 记录训练过程中的准确率和损失变化

练习2:高级技巧

在练习1的基础上:

- 添加EarlyStopping回调

- 实现学习率衰减

- 使用ModelCheckpoint保存最佳模型

练习3:自定义训练

尝试使用自定义训练循环实现练习1的任务,比较与fit()方法的差异。

通过本文的学习,你应该已经掌握了TensorFlow模型训练的核心流程和关键技巧。实际应用中,需要根据具体问题和数据特点调整训练策略。建议从简单模型开始,逐步增加复杂度,并通过实验找到最佳的训练配置。

点我分享笔记