语言学基础

自然语言处理(NLP)作为人工智能的重要分支,其核心是让计算机理解、解释和生成人类语言。要掌握NLP,首先需要了解支撑人类语言运作的基本原理 - 这就是语言学基础。

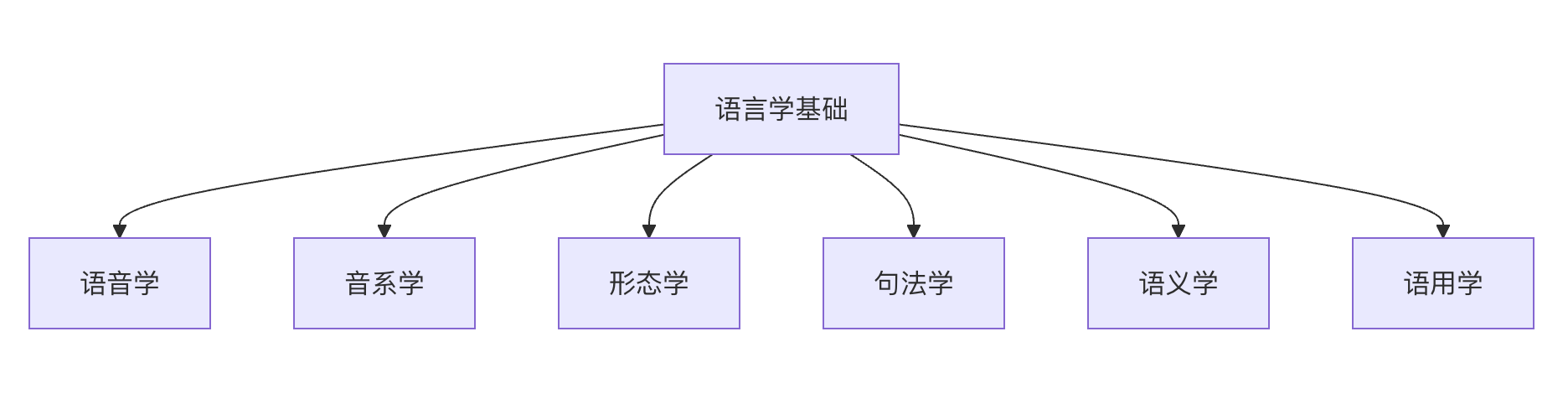

语言学基础为 NLP 提供了理论框架和分析工具,主要包括以下几个关键方面:

- 语音学(Phonetics):研究语言的声音系统

- 音系学(Phonology):研究声音如何组合形成有意义的语言单位

- 形态学(Morphology):研究词的内部结构

- 句法学(Syntax):研究句子结构

- 语义学(Semantics):研究语言的意义

- 语用学(Pragmatics):研究语言在语境中的使用

语音学与音韵学(Phonetics & Phonology)

语音学(Phonetics)

语音学研究语音的物理特性和产生机制,关注语音的声学和生理特征。

发音器官与发音方式

- 发音器官:

- 肺部:提供气流

- 喉头:声带振动产生浊音

- 口腔:舌头、牙齿、嘴唇调节气流

- 鼻腔:产生鼻音

辅音分类

按照发音方式和发音部位分类:

-

发音方式:

- 塞音:/p/, /b/, /t/, /d/, /k/, /g/

- 擦音:/f/, /v/, /s/, /z/

- 塞擦音:/ts/, /tʃ/

- 鼻音:/m/, /n/, /ŋ/

- 边音:/l/

- 颤音:/r/

-

发音部位:

- 双唇音:/p/, /b/, /m/

- 唇齿音:/f/, /v/

- 舌尖音:/t/, /d/, /n/

- 舌根音:/k/, /g/, /ŋ/

元音分类

按照舌位和唇形分类:

- 舌位高低:高元音/i/, /u/,中元音/e/, /o/,低元音/a/

- 舌位前后:前元音/i/, /e/,央元音/a/,后元音/u/, /o/

- 唇形:圆唇音/u/, /o/,不圆唇音/i/, /e/, /a/

汉语语音特点

- 声调语言:声调具有区别意义的作用

- 普通话四个基本声调:阴平、阳平、上声、去声

- 例:妈(mā) 麻(má) 马(mǎ) 骂(mà)

- 音节结构:声母+韵母的结构

- 声母:21个基本声母

- 韵母:39个基本韵母

音韵学(Phonology)

音韵学研究语音系统的结构和规律,关注语音在特定语言中的功能。

音位(Phoneme)

- 具有区别意义功能的最小语音单位

- 例:英语中/p/和/b/是不同音位(pit vs bit)

- 汉语中声调是音位的组成部分

音位变体(Allophone)

- 同一音位在不同环境中的语音实现

- 例:英语/p/在不同位置的送气程度不同

音韵规则

- 描述语音在特定环境中的变化规律

- 例:汉语的"一"字变调规律

- 英语的复数形式语音变化:cats /s/, dogs /z/, horses /ɪz/

在NLP中的应用

- 语音识别:将声音信号转换为文本

- 语音合成:将文本转换为语音

- 音字转换:拼音到汉字的转换

- 韵律分析:诗歌韵律的计算分析

形态学(Morphology)

形态学研究词的内部结构和构词规律,是词汇层面分析的基础。

基本概念

词素(Morpheme)

- 语言中最小的有意义的语法单位

- 自由词素:可以独立使用的词素,如"书"、"run"

- 粘着词素:必须附着在其他词素上,如前缀、后缀

词根、词缀和词干

- 词根(Root):词的核心意义承载者

- 例:在"unhappiness"中,"happy"是词根

- 词缀(Affix):

- 前缀(Prefix):un-, re-, pre-

- 后缀(Suffix):-ness, -tion, -ly

- 中缀(Infix):较少见,如他加禄语

- 词干(Stem):去掉屈折词缀后的形式

构词方式

派生(Derivation)

- 通过添加派生词缀改变词性或词义

- 例:

- happy → unhappy(添加否定前缀)

- happy → happiness(名词化后缀)

- teach → teacher(施事后缀)

复合(Compounding)

- 将两个或多个词根结合成新词

- 英语例子:

- blackboard(black + board)

- laptop(lap + top)

- 中文例子:

- 电脑(电 + 脑)

- 手机(手 + 机)

屈折(Inflection)

- 改变词的语法形式但不改变基本词义

- 英语动词变位:walk, walks, walked, walking

- 名词复数:book → books, child → children

- 中文的屈折变化相对较少

中文形态学特点

词的概念

- 中文词的边界相对模糊

- 字、词、短语的界限不如英文明确

- 例:"研究生"可以是一个词,也可以分析为"研究"+"生"

构词方式

-

复合为主:

- 偏正式:火车(火+车)

- 动宾式:司机(司+机)

- 主谓式:地震(地+震)

- 并列式:朋友(朋+友)

-

重叠构词:

- 动词重叠:看看、走走

- 形容词重叠:红红的、慢慢地

- 名词重叠:人人、事事

词类活用

- 同一个字或词可以充当不同词性

- 例:"水"可以是名词(喝水)或动词(水稻田)

在NLP中的应用

词干提取(Stemming)

- 将词汇还原到词干形式

- Porter算法:将"running", "runs", "ran"都还原为"run"

词形还原(Lemmatization)

- 将词汇还原到词典形式(引理)

- 考虑词性信息,更准确

中文分词

- 由于中文词间无空格分隔,需要进行分词处理

- 基于词典、统计或神经网络的方法

词性标注

- 确定每个词的语法类别

- 为句法分析提供基础信息

句法学(Syntax)

句法学研究句子的结构和组织规律,是理解语言语法的核心。

基本概念

短语结构

- 名词短语(NP):以名词为中心的短语

- 例:那本有趣的书

- 动词短语(VP):以动词为中心的短语

- 例:快速地跑步

- 介词短语(PP):以介词为中心的短语

- 例:在桌子上

- 形容词短语(AP):以形容词为中心的短语

- 例:非常美丽

句子成分

- 主语(Subject):动作的执行者

- 谓语(Predicate):描述主语的动作或状态

- 宾语(Object):动作的承受者

- 定语(Attributive):修饰名词的成分

- 状语(Adverbial):修饰动词、形容词的成分

- 补语(Complement):补充说明的成分

句法分析方法

短语结构文法(Phrase Structure Grammar)

- 用重写规则描述句子结构

- 例:

S → NP VP NP → Det N VP → V NP Det → the, a, an N → cat, dog, book V → chase, read

依存文法(Dependency Grammar)

- 以词与词之间的依存关系为核心

- 每个词依存于一个中心词(除了根节点)

- 例:在"小猫追老鼠"中:

- "追"是根节点

- "小猫"依存于"追"(主谓关系)

- "老鼠"依存于"追"(动宾关系)

- "小"依存于"猫"(定中关系)

树形表示

追

/ \

小猫 老鼠

/

小

中文句法特点

语序特点

- 基本语序:主-谓-宾(SVO)

- 修饰语在被修饰语前:的字结构

- 例:那个穿红衣服的美丽女孩

特殊结构

- 把字句:把+宾语+动词

- 例:我把书放在桌子上

- 被字句:主语+被+施事者+动词

- 例:书被我放在桌子上

- 存现句:表示存在或出现

- 例:桌子上放着一本书

语法化程度

- 中文的语法化程度相对较低

- 词序和语境在表达语法关系中起重要作用

- 缺乏丰富的形态变化

句法分析的挑战

歧义问题

- 结构歧义:一个句子可以有多种句法分析

- 例:"我看见了拿着望远镜的人"

- 分析1:我用望远镜看见了人

- 分析2:我看见了一个拿着望远镜的人

长距离依赖

- 句子成分之间的依赖关系可能跨越很大距离

- 例:在问句"什么书你昨天买了?"中,"什么"与"买"之间存在依赖关系

省略现象

- 中文经常省略主语或其他成分

- 例:(我)昨天看了电影,(电影)很好看

在NLP中的应用

句法分析器

- 基于规则:使用手工编写的语法规则

- 统计方法:基于标注语料库的概率模型

- 深度学习:使用神经网络进行端到端学习

句法树库

- Penn Treebank(英文)

- 中文树库(CTB)

- 为句法分析提供训练和评估数据

应用任务

- 机器翻译:理解源语言句法结构

- 信息抽取:基于句法模式抽取信息

- 问答系统:理解问句的句法结构

语义学(Semantics)

语义学研究语言的意义,是自然语言理解的核心。

基本概念

词汇语义

- 词义:词汇所表达的概念或意义

- 多义性:一个词有多个相关意义

- 同义关系:不同词汇表达相同或相似意义

- 反义关系:词汇间的对立关系

- 上下位关系:概念间的包含关系

语义关系

- 同义词(Synonyms):

- 完全同义:较少见

- 近义词:快乐-高兴,大-巨大

- 反义词(Antonyms):

- 互补反义:死-活,男-女

- 等级反义:冷-热,大-小

- 关系反义:老师-学生,买-卖

- 上下位词:

- 上位词:动物、颜色

- 下位词:狗、猫(动物的下位词)

句子语义

命题(Proposition)

- 句子所表达的基本语义内容

- 例:句子"小明在图书馆看书"表达的命题:

- 施事者:小明

- 动作:看

- 受事者:书

- 地点:图书馆

语义角色(Semantic Roles)

- 施事者(Agent):动作的执行者

- 受事者(Patient):动作的承受者

- 工具(Instrument):完成动作所使用的工具

- 地点(Location):动作发生的地点

- 时间(Time):动作发生的时间

- 方式(Manner):动作的方式

论元结构(Argument Structure)

- 动词所要求的语义参与者

- 例:动词"给"要求三个论元:

- 给予者(施事)

- 接受者(与事)

- 给予物(受事)

语义表示

逻辑表示

- 使用逻辑公式表示语义

- 一阶逻辑:∃x (人(x) ∧ 高兴(x))

- 例:句子"有人很高兴"的逻辑表示

框架语义学(Frame Semantics)

- 基于认知框架理解语义

- FrameNet项目:构建基于框架的语义资源

- 例:商业交易框架包含买方、卖方、商品、价格等要素

概念图

- 使用图结构表示概念和关系

- 节点代表概念,边代表关系

- 适合表示复杂的语义网络

语义歧义

词汇歧义

- 一词多义:银行(金融机构/河岸)

- 同音异义:他们/它们

结构歧义

- 修饰歧义:"漂亮的女孩的衣服"

- 范围歧义:"所有学生都不及格"

语用歧义

- 需要上下文才能确定意义

- 例:代词指代、省略成分的恢复

在NLP中的应用

词汇语义资源

- WordNet:英文词汇语义网络

- HowNet:中文词汇语义知识库

- 同义词词林:中文同义词分类体系

语义分析任务

- 词义消歧:确定多义词在特定上下文中的含义

- 语义角色标注:识别句子中的语义角色

- 语义相似度计算:计算词汇或句子间的语义相似度

应用领域

- 问答系统:理解问题的语义意图

- 机器翻译:保持翻译的语义一致性

- 信息检索:基于语义进行相关性匹配

语用学(Pragmatics)

语用学研究语言在具体交际情境中的使用,关注语境对意义的影响。

基本概念

语境(Context)

- 语言语境:上下文信息

- 情景语境:交际的具体情境

- 文化语境:社会文化背景

言语行为理论(Speech Act Theory)

- 言内行为:说话行为本身

- 言外行为:通过说话要达到的目的

- 言后行为:说话产生的效果

言外行为类型

- 断言类:陈述事实,如"今天下雨了"

- 指令类:要求行动,如"请关门"

- 承诺类:承诺未来行动,如"我明天来"

- 表达类:表达态度,如"恭喜你"

- 宣告类:改变现状,如"我宣布会议开始"

语用现象

指示语(Deixis)

- 依赖语境才能确定所指的语言成分

- 人称指示:我、你、他

- 时间指示:现在、昨天、明天

- 空间指示:这里、那里、上面

- 语篇指示:如上所述、综上所言

预设(Presupposition)

- 说话者假定听话者已知的信息

- 例:"小明的妻子很漂亮"预设小明已婚

含义(Implicature)

- 会话含义:通过违反合作原则产生的隐含意义

- 例:A:"你知道几点了吗?" B:"知道。"

- B的回答违反了量准则,暗示不愿透露时间

合作原则(Cooperative Principle)

- 量准则:提供适量信息

- 质准则:说真话

- 关系准则:说相关的话

- 方式准则:表达清楚

中文语用特点

礼貌策略

- 中文非常注重礼貌原则

- 使用委婉语和敬语

- 例:请问、麻烦您、不好意思

高语境文化

- 依赖语境理解意义

- 话语含蓄,不直接表达

- 例:中文的拒绝常常是间接的

面子理论

- 积极面子:被认可的需要

- 消极面子:不被打扰的需要

- 影响言语行为的选择

在NLP中的应用

对话系统

- 意图识别:理解用户的真实意图

- 槽位填充:提取对话中的关键信息

- 对话管理:控制对话流程

情感分析

- 隐含情感:识别间接表达的情感

- 反讽检测:理解反话的真实含义

机器翻译

- 语用等价:保持原文的语用功能

- 文化适应:考虑目标语言的文化特点

中文语言特点

中文作为汉语系的代表,具有独特的语言特点,这些特点为中文NLP带来了特殊的挑战和机遇。

分词的必要性

无空格分隔

- 中文词与词之间没有明显的分界符

- 例:「我爱北京天安门」需要分解为「我/爱/北京/天安门」

- 与英文等语言的天然分词不同

词的概念复杂

- 字、词、短语的界限模糊

- 例:「研究」可以是一个词,「研究生」也可以是一个词

- 上下文影响分词结果

分词歧义

组合歧义

- 同一字符序列可以有不同的分词方式

- 例:「结婚的和尚未结婚的」

- 错误分词:结婚的/和尚/未结婚的

- 正确分词:结婚的/和/尚未/结婚的

交集歧义

- 相邻的分词方案有重叠

- 例:「长春市长春药店」

- 方案1:长春市/长春/药店

- 方案2:长春/市长/春药店

真歧义

- 不同分词结果都在语法和语义上合理

- 例:「乒乓球拍卖完了」

- 方案1:乒乓球拍/卖完了

- 方案2:乒乓球/拍卖/完了

分词方法

基于词典的方法

- 最大匹配算法(正向、逆向、双向)

- 优点:简单高效

- 缺点:无法处理歧义和未登录词

基于统计的方法

- N-gram语言模型

- 隐马尔可夫模型(HMM)

- 条件随机场(CRF)

基于深度学习的方法

- 双向LSTM + CRF

- BERT等预训练模型

- 字符级神经网络

汉字、词汇与语法结构

汉字特点

方块字结构

- 汉字具有方形的视觉特征

- 每个字占据等宽的空间

- 字形、字音、字义的统一

象形表意特征

- 象形字:日、月、山、水

- 指事字:上、下、本、末

- 会意字:明、休、信

- 形声字:占汉字的80%以上,如:江(氵+工)

多音多义现象

- 一字多音:行(xíng/háng)、长(cháng/zhǎng)

- 一字多义:「打」有击打、购买、制作等多种含义

词汇特点

构词方式丰富

- 单纯词:不能拆分,如:桌子、葡萄

- 合成词:由两个或多个语素组成

- 复合式:电脑、手机

- 附加式:第一、老师

词汇语义透明度高

- 从组成汉字可以推测词义

- 例:「洗衣机」= 洗 + 衣 + 机

- 有助于理解新词和术语

词类转换灵活

- 同一词汇可以充当不同词性

- 例:「水」

- 名词:喝水

- 动词:水田

- 形容词:水平很水(口语)

语法结构特点

语序相对固定

- 基本语序:主-谓-宾(SVO)

- 定语在中心语前:红色的花

- 状语在谓语前:慢慢地走

语法手段多样

- 语序:改变词序表达不同意思

- 虚词:的、地、得、了、着、过等

- 重叠:看看、走走、红红的

语法化程度低

- 缺乏丰富的词形变化

- 动词无时态、语态的形态变化

- 名词无格变、数的一致性要求

中文NLP的特殊挑战

文本预处理挑战

分词困难

- 歧义消解需要语义理解

- 新词识别困难

- 专业领域词汇识别

简繁转换

- 一简对多繁:后(後/后)

- 一繁对多简:髮(发/髪)

- 地区用词差异:计算机/电脑

编码问题

- 多种编码方式:GB2312、GBK、UTF-8

- 编码转换可能导致信息丢失

语言变体处理

方言差异

- 语音、词汇、语法的地区差异

- 例:北京话的"倍儿"、上海话的"阿拉"

- 影响语音识别和文本理解

文体差异

- 古文与现代文

- 正式语体与口语

- 网络用语和流行语

港澳台用语

- 用词习惯不同:的士/出租车、巴士/公交车

- 语法结构差异:有冇(有没有)

- 外来词处理:音译vs意译

语义理解挑战

语境依赖性强

- 代词指代复杂

- 省略现象频繁

- 需要更多上下文信息

文化内涵丰富

- 成语、典故的理解

- 文化特有概念:面子、关系

- 传统文化背景知识

语言使用灵活

- 语序变化:把字句、被字句

- 表达方式多样:委婉、含蓄

- 语用原则的文化特色

文本的层次结构

文本作为语言的载体,具有多层次的结构特征。理解这些层次结构对于设计有效的NLP系统至关重要。

字符层面(Character Level)

基本单位

字符定义

- 文本的最小视觉单位

- 包括字母、汉字、数字、标点符号等

- Unicode编码系统的基本单元

字符类型

- 字母字符:A-Z, a-z

- 数字字符:0-9

- 汉字字符:Unicode范围4E00-9FFF

- 标点符号:。,!?;:""''

- 特殊字符:@#$%^&*等

字符级处理

编码处理

- ASCII编码:适用于英文

- Unicode编码:支持多语言

- UTF-8编码:变长编码,广泛使用

字符序列模型

- 字符级RNN:直接处理字符序列

- 卷积神经网络:提取字符级特征

- Transformer:自注意力机制处理字符

应用场景

- 拼写检查:检测字符级错误

- 文本生成:字符级语言模型

- 低资源语言:缺乏词汇资源时的备选方案

词汇层面(Word Level)

词汇定义

词的概念

- 具有完整意义的语言单位

- 语法分析的基本单元

- 在语音上具有相对独立性

词汇类型

- 实词:名词、动词、形容词、副词

- 虚词:介词、连词、助词、叹词

- 功能词:the, a, is, have等高频功能性词汇

- 内容词:承载主要意义的词汇

词汇表示

独热编码(One-hot Encoding)

- 每个词用一个向量表示

- 向量长度等于词汇表大小

- 只有对应位置为1,其他为0

- 缺点:维度高,无法表示语义相似性

词向量(Word Embeddings)

- Word2Vec:基于神经网络的词向量

- CBOW:根据上下文预测中心词

- Skip-gram:根据中心词预测上下文

- GloVe:基于全局词汇统计信息

- FastText:考虑字符级信息的词向量

上下文词向量

- ELMo:双向LSTM生成的上下文敏感表示

- BERT:基于Transformer的双向编码器

- 同一词在不同上下文中有不同表示

词汇关系

语义关系

- 同义关系:快乐-高兴

- 反义关系:大-小

- 上下位关系:动物-狗

形态关系

- 词根关系:run-running-ran

- 派生关系:happy-happiness

- 复合关系:black + board → blackboard

分布关系

- 具有相似上下文分布的词汇往往语义相关

- 例:"医生"和"护士"常在相似语境出现

- 是词向量学习的基础假设

词汇级处理

词汇规范化

- 大小写处理:将文本统一为小写或大写

- 词形还原:将词汇还原为词典形式(lemma)

- 词干提取:去除词缀得到词干(stem)

停用词过滤

- 移除高频低信息量词汇

- 中文停用词:的、了、是、在、和等

- 英文停用词:the, a, an, is, are等

低频词处理

- 替换为统一标记(如<UNK>)

- 提高模型泛化能力

- 减少词汇表规模

应用场景

- 信息检索:建立倒排索引

- 文本分类:特征提取与表示

- 机器翻译:词汇对齐与替换

短语层面(Phrase Level)

短语定义

基本概念

- 由多个词组成的语法单位

- 具有内部结构和外部功能

- 围绕一个中心词展开

短语类型

- 名词短语(NP):以名词为中心

- 例:一本有趣的书

- 动词短语(VP):以动词为中心

- 例:正在认真阅读

- 介词短语(PP):以介词为中心

- 例:在桌子上

- 形容词短语(AP):以形容词为中心

- 例:非常漂亮

短语识别

基于规则的方法

- 使用语法规则模板

- 例:NP → (Det) (Adj) N

- 依赖人工编写的语法规则

基于统计的方法

- 使用n-gram模型识别常见短语

- 基于互信息、卡方检验等统计量

- 例:"纽约时报"作为固定短语

基于深度学习的方法

- 序列标注模型(如BiLSTM-CRF)

- 端到端的短语检测

- 预训练语言模型(如BERT)

短语表示

词向量组合

- 简单平均:取组成词向量的平均值

- 加权平均:根据词重要性分配权重

- 递归神经网络:考虑词序的组合

短语嵌入

- 直接学习短语级别的向量表示

- Skip-phrase模型:类似Skip-gram

- 短语类比任务:中国:北京::法国:巴黎

应用场景

- 信息抽取:识别关键短语

- 查询理解:处理搜索引擎查询

- 情感分析:识别评价对象短语

句子层面(Sentence Level)

句子定义

基本概念

- 表达完整意思的语言单位

- 具有语法独立性

- 包含主语和谓语的基本结构

句子类型

- 陈述句:表达事实或观点

- 疑问句:提出问题

- 祈使句:表达请求或命令

- 感叹句:表达强烈情感

句子表示

词向量组合

- 词袋模型(BoW):忽略词序的简单加和

- TF-IDF加权:考虑词的重要性

- 序列模型:RNN/LSTM考虑词序信息

句子嵌入

- Skip-Thought:预测上下文句子

- InferSent:基于监督任务的表示

- Sentence-BERT:基于BERT的句子表示

句法结构表示

- 依存树:表示词间依存关系

- 成分树:表示短语结构关系

- 图表示:结合多种关系

句子级处理

句子分割

- 将连续文本分割为句子

- 中文难点:句号的多功能性

- 方法:基于规则、机器学习

句子压缩

- 保留核心信息的简化

- 删除冗余成分

- 应用于摘要生成

句子改写

- 保持语义的句式变换

- 主动被动转换

- 应用于数据增强

应用场景

- 机器翻译:句子级对齐与生成

- 文本摘要:关键句子抽取

- 问答系统:问句理解与答案生成

篇章层面(Discourse Level)

篇章结构

基本概念

- 由多个句子组成的连贯整体

- 具有主题一致性和逻辑连贯性

- 包括引言、主体、结论等结构

衔接手段

- 指代:代词、指示词

- 连接词:因为、所以、但是

- 词汇衔接:重复、同义、上下位

- 省略:承前或蒙后省略

篇章关系

- 因果关系:因为…所以…

- 转折关系:虽然…但是…

- 并列关系:一方面…另一方面…

- 时序关系:首先…然后…最后…

篇章分析

指代消解

- 确定代词或名词短语的指代对象

- 例:"小明迟到了。他很抱歉。"中"他"指代"小明"

- 方法:基于规则、机器学习、深度学习

主题建模

- LDA:潜在狄利克雷分配

- 发现文本的潜在主题分布

- 应用于文本聚类和分类

情感轨迹分析

- 跟踪篇章中情感的变化

- 识别情感转折点

- 应用于评论分析和文学研究

篇章表示

全局向量

- 平均所有句子向量

- 加权平均(如TF-IDF权重)

- 层次化组合

图表示

- 节点表示句子或概念

- 边表示关系

- 应用于摘要生成

记忆网络

- 存储和检索篇章信息

- 处理长距离依赖

- 应用于问答系统

应用场景

- 自动摘要:提取核心内容

- 问答系统:多句推理

- 文本生成:保持篇章连贯

语言模型与概率语法

语言模型基础

基本概念

语言模型定义

- 计算词序列概率的模型

- 评估句子的流畅度和合理性

- 形式化描述:P(w₁,w₂,…,wₙ)

应用领域

- 语音识别:选择最可能的词序列

- 机器翻译:评估翻译候选

- 文本生成:预测下一个词

N-gram模型

马尔可夫假设

- 当前词只依赖前n-1个词

- 简化概率计算:P(wᵢ|w₁,…,wᵢ₋₁) ≈ P(wᵢ|wᵢ₋ₙ₊₁,…,wᵢ₋₁)

模型训练

- 最大似然估计

- 计数与归一化

- 平滑技术(加一、Good-Turing等)

局限性

- 数据稀疏问题

- 长距离依赖难以捕捉

- 上下文信息有限

神经网络语言模型

前馈神经网络模型

基本结构

- 输入层:前n-1个词的one-hot表示

- 嵌入层:学习词向量

- 隐藏层:非线性变换

- 输出层:预测下一个词的概率分布

优势

- 分布式表示缓解数据稀疏

- 自动学习特征组合

- 更好的泛化能力

循环神经网络模型

RNN结构

- 循环处理变长序列

- 隐藏状态传递历史信息

- 应用于语言建模

LSTM/GRU

- 解决梯度消失问题

- 长距离依赖建模

- 更稳定的训练过程

Transformer模型

自注意力机制

- 全局上下文建模

- 并行计算优势

- 位置编码处理词序

预训练语言模型

- BERT:双向上下文表示

- GPT:自回归生成模型

- 强大的迁移学习能力

概率语法模型

概率上下文无关文法

基本概念

- 为CFG规则赋予概率

- P(X → γ)表示规则应用概率

- 句子的概率是推导路径概率的乘积

参数估计

- 从树库中计数规则应用

- 最大似然估计

- 平滑处理稀疏规则

应用

- 句法分析

- 句子概率评估

- 歧义消解

依存语法模型

概率依存文法

- 为依存关系赋予概率

- 基于词汇共现统计

- 考虑距离和语法约束

解析算法

- 基于图的算法(Eisner算法)

- 基于转移的算法

- 神经网络解析器

语言资源与标注

语料库资源

通用语料库

英文语料库

- Brown Corpus

- British National Corpus (BNC)

- Corpus of Contemporary American English (COCA)

中文语料库

- 北京大学现代汉语语料库

- 国家语委现代汉语平衡语料库

- 中文维基百科语料

标注语料库

词性标注语料

- Penn Treebank

- 中文树库(CTB)

句法树库

- Penn Treebank

- Chinese Dependency Treebank

语义标注语料

- PropBank(语义角色)

- FrameNet(框架语义)

- Semeval(语义关系)

词汇语义资源

英文资源

WordNet

- 同义词集合(synset)

- 词汇关系网络

- 广泛用于NLP研究

FrameNet

- 基于框架语义学

- 标注语义角色

- 丰富的例句资源

中文资源

HowNet

- 中英文概念词典

- 义原分析系统

- 语义关系网络

同义词词林

- 中文同义词分类

- 层次化组织结构

- 词汇扩展资源

评估数据集

标准任务数据集

分词与词性标注

- PKU标注语料

- MSRA标注语料

句法分析

- Chinese Treebank

- CTB 5.1/6.0/7.0

语义分析

- Chinese PropBank

- NLPCC评测数据

应用任务数据集

文本分类

- THUCNews

- Fudan Corpus

情感分析

- ChnSentiCorp

- Weibo Sentiment Corpus

问答系统

- NLPCC QA数据集

- WebQA

语言学与NLP的交叉研究

计算语言学

研究领域

语音技术

- 语音识别

- 语音合成

- 语音转换

语法分析

- 自动句法分析

- 文法归纳

- 树库构建

语义计算

- 词义消歧

- 语义角色标注

- 语义相似度

认知语言学与NLP

语言习得建模

儿童语言习得

- 词汇增长模型

- 语法发展模拟

- 认知启发的NLP

神经认知模型

- 大脑语言处理模拟

- 神经符号系统

- 多模态学习

语言进化建模

计算模拟

- 词汇形成

- 语法涌现

- 文化传播

多智能体系统

- 交流系统演化

- 符号接地问题

- 语言游戏模型

社会语言学与NLP

语言变异处理

方言识别

- 语音特征分析

- 词汇差异建模

- 方言机器翻译

社会语言特征

- 年龄、性别识别

- 教育水平预测

- 地域方言分析

语言政策支持

语言资源建设

- 少数民族语言

- 濒危语言保护

- 多语言技术开发

语言教育技术

- 计算机辅助学习

- 自动作文评分

- 个性化教学系统

点我分享笔记